Inteligencia artificial: ¿aprobará el examen de conducir?

La inteligencia artificial está presente en cada vez más ámbitos de nuestra vida cotidiana. ¿Pasaría el examen de conducir?

Mercedes-Benz quiere probar la inteligencia artificial (IA) en la producción de automóviles. Bosch subraya que el coche de hoy es el verdadero friki, porque la IA aprende tres veces más rápido que un humano al volante. Hace tiempo que está a bordo para la transmisión de música, la navegación y los asistentes de voz digitales, y la conducción autónoma es inconcebible sin la IA. ¿Tendremos que acostumbrarnos al copiloto que todo lo sabe y todo lo puede hacer mejor que nosotros?

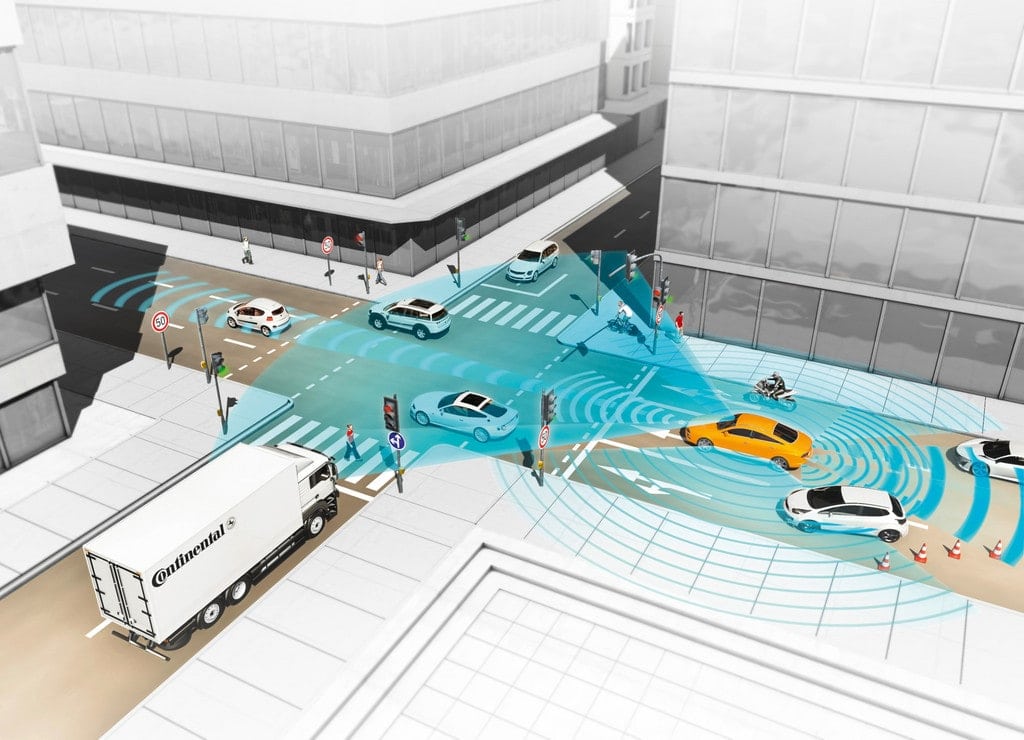

Conducción totalmente automatizada o autónoma para mayor seguridad. Foto: Auto-Medienportal.Net/Continental

Reconocer a los peatones

El Prof. Dr. Simon Burton, Director Científico de Garantía de Seguridad de Fraunhofer IKS Munich, sabe que la IA es de crucial importancia para la conducción autónoma y altamente automatizada, "porque los sistemas basados en IA garantizan que los vehículos autónomos puedan enfrentarse a los complejos escenarios del tráfico rodado". Los vehículos autónomos necesitan percibir su entorno y reaccionar adecuadamente ante él. Por ejemplo, es importante que reconozcan sin errores a los peatones en todo momento y que de ello se derive la reacción correcta.

¿Seguro en todo momento?

Sin embargo, cuando se trata del uso de la IA en vehículos autónomos, el profesor Burton se pregunta: "¿Es la IA lo suficientemente segura como para demostrar su uso en un ámbito tan crítico para la seguridad como el tráfico rodado?". Al fin y al cabo, no es fácil reconocer cómo llegan a una conclusión los sistemas de IA e incluso ligeros cambios en los datos de entrada, por ejemplo, conducen a un resultado completamente distinto. "En el tráfico rodado, sin embargo, las decisiones de la IA deben ser comprensibles y la seguridad funcional debe estar garantizada en todo momento", exige el de Fraunhofer.

Conducción autónoma. Foto: Auto-Medienportal.Net/Continental

Hoy en día, la inteligencia artificial está demostrando sus capacidades en el automóvil y en muchos otros ámbitos de aplicación: en la industria para controlar dispositivos y máquinas, en la robótica, en los procesos de automatización e incluso en la medicina, donde proporciona un valioso apoyo a los médicos, sobre todo en el diagnóstico. O en forma de aplicaciones de salud, que ya forman parte del estilo de vida de algunas personas. Al mismo tiempo, los debates sobre los límites y riesgos de la IA siguen cobrando fuerza.

Reconocer dónde falla

En un artículo publicado en el actual número 619 de la revista científica "Nature", Celeste Biever analiza cómo los LLM (grandes modelos lingüísticos) basados en IA fracasan en tareas comparativamente sencillas de pruebas de inteligencia estandarizadas. El hecho de que modelos que aprueban sin esfuerzo los exámenes de acceso a universidades de renombre y dominan complicados requisitos en muchas áreas en un tiempo récord fallen regularmente en tareas de abstracción sencillas ha causado revuelo. Su alegato ante este telón de fondo: "Tenemos que entender fundamentalmente qué pueden hacer y en qué fallan". En el trasfondo está la cuestión de si los sistemas de IA pueden clasificarse como "genios" ilimitados o si, después de todo, las capacidades de la inteligencia artificial no son limitadas.

Ambas cosas, dice el profesor Marco Barenkamp, experto en IA y Vicepresidente del Consejo de Supervisión y fundador de LMIS AG en Osnabrück, especializada en la aplicación de la IA en la industria.

ChatGPT vs. humano

ChatGPT, de la start-up estadounidense OpenAI, o Bard, de Google, así como otros LLM, han dominado muchas habilidades que hace sólo unos años habrían sido celebradas como un hito en la inteligencia artificial. El profesor Barenkamp explica la importancia de este desarrollo: los bots responden a preguntas con elocuencia y asombran con sus asombrosos conocimientos generales. Sin embargo, el modelo de transformador "Chat Generative Pre-trained Transformer", que es el nombre completo de ChatGPT, ya tiene considerables dificultades con sencillos rompecabezas de lógica visual, mientras que los humanos suelen dominar esas tareas sin esfuerzo. Esta es una característica que los conductores normales deberían temer.

Evaluar la IA de forma realista

En este contexto, los científicos se preguntan cómo evaluar de forma realista las capacidades de ChatGPT. El profesor Barenkamp se refiere a un estudio que recientemente ha atraído cierta atención en el mundo académico y que también es la base del ensayo de Celeste Biever: un equipo dirigido por Melanie Mitchell, del Santa Fe Institute, presentó al modelo de lenguaje GPT 4 tareas en las que había que ordenar bloques de colores en una cuadrícula. Se utilizaron varios ejemplos para deducir la regla subyacente y predecir cómo cambiarían los bloques a continuación.

"La mayoría de la gente resuelve estas tareas sin esfuerzo", explica el profesor Barenkamp. GPT 4, en cambio, sólo acertó un tercio en una categoría y sólo el tres por ciento en otras. Otros sistemas de IA desarrollados especialmente para este tipo de rompecabezas obtuvieron mejores resultados que los humanos, pero aún así fueron bastante peores.

El estudio demuestra que actualmente sigue siendo difícil para los sistemas artificiales reconocer los conceptos subyacentes y aprender de ellos, resume el experto Barenkamp. Sin embargo, uno de los rasgos distintivos de la inteligencia humana es precisamente la capacidad de abstracción y transferencia a nuevas situaciones, subraya.

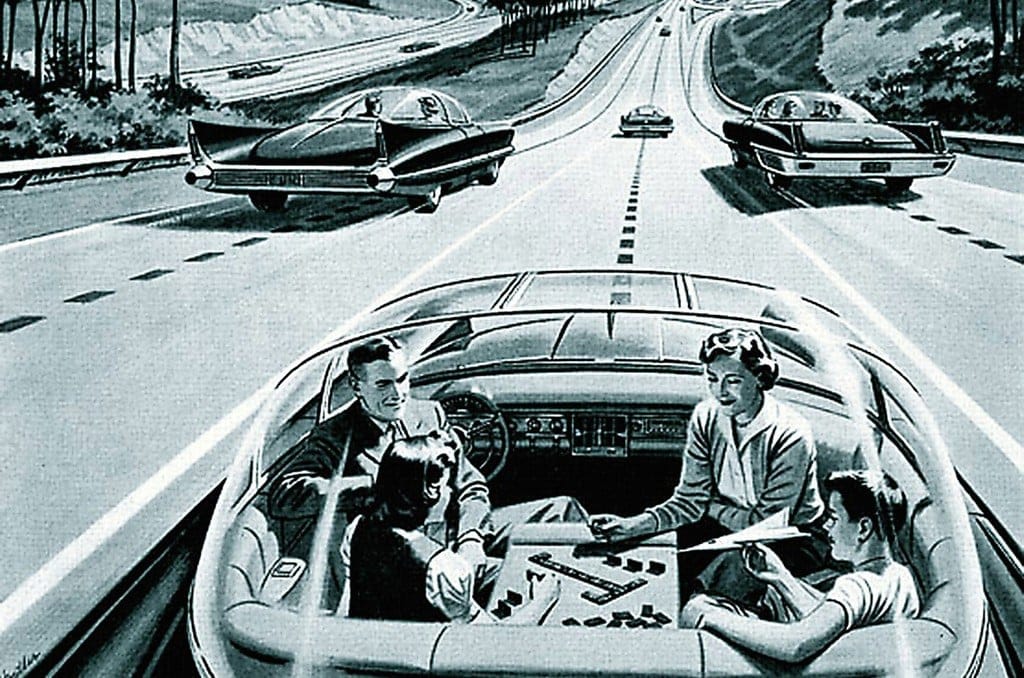

Conducción autónoma: Un sueño en los años 50. Foto: Auto-Medienportal.Net/Wikipedia

Aprender de forma diferente a los humanos

¿Por qué los sistemas de IA siguen siendo tan claramente inferiores a los humanos en habilidades tan básicas, mientras que a veces sorprenden con una elocuencia sorprendente en las conversaciones? El profesor Barenkamp lo explica diciendo que las aplicaciones de IA aprenden de forma distinta a los humanos. Por ejemplo, los grandes modelos lingüísticos, como GPT 4, se entrenan examinando grandes cantidades de texto. Al hacerlo, la IA reconoce correlaciones estadísticas entre palabras, como explica el profesor Barenkamp, para determinar la siguiente palabra más probable dada una entrada. El ser humano, en cambio, ya tiene experiencias concretas con objetos y situaciones cuando es niño, construye su propia imagen (representación) del mundo y desarrolla capacidades cognitivas como la capacidad de abstracción y el pensamiento lógico.

Según el experto en IA Barenkamp, esto puede explicar por qué GPT 4 es capaz de producir textos de gran calidad, como los escritos por humanos, pero falla en pruebas visuales sencillas: porque en este caso el entrenamiento se basa exclusivamente en el lenguaje y no en experiencias reales y en la necesaria conexión del lenguaje con cosas concretas y experimentadas. Por ello, algunos investigadores sospechan que los sistemas de IA no "entienden" las palabras como los humanos, lo que les impide desarrollar una verdadera conceptualización del mundo.

Así que, por decirlo sarcásticamente: la IA puede decirnos mucho, pero los procesos en el tráfico pueden seguir siendo demasiado complejos para ella. En los próximos años, los conductores probablemente experimentarán la IA más en el ámbito de la comodidad en los sistemas de infoentretenimiento y asistencia. El camino hacia la conducción totalmente automatizada es probablemente más largo de lo que pensaban los responsables de San Francisco, que autorizaron el uso de taxis autónomos y ahora tienen que lidiar con atascos por culpa de las máquinas expendedoras de taxis.

(aum)

Más enlaces: